超算建设如火如荼,无论是主权 AI 还是科技巨头,都在源源不断地给英伟达输血、建数据中心。

前段时间,马斯克建成的有 10 万张 H100 的 Colossus 集群,号称是世界上最强大的 AI 训练系统。

而在这之前,截止到 2023 年 12 月,世界上运算速度最快的超算,是位于美国田纳西州橡树岭的 Frontier,也被称为 OLCF-5。

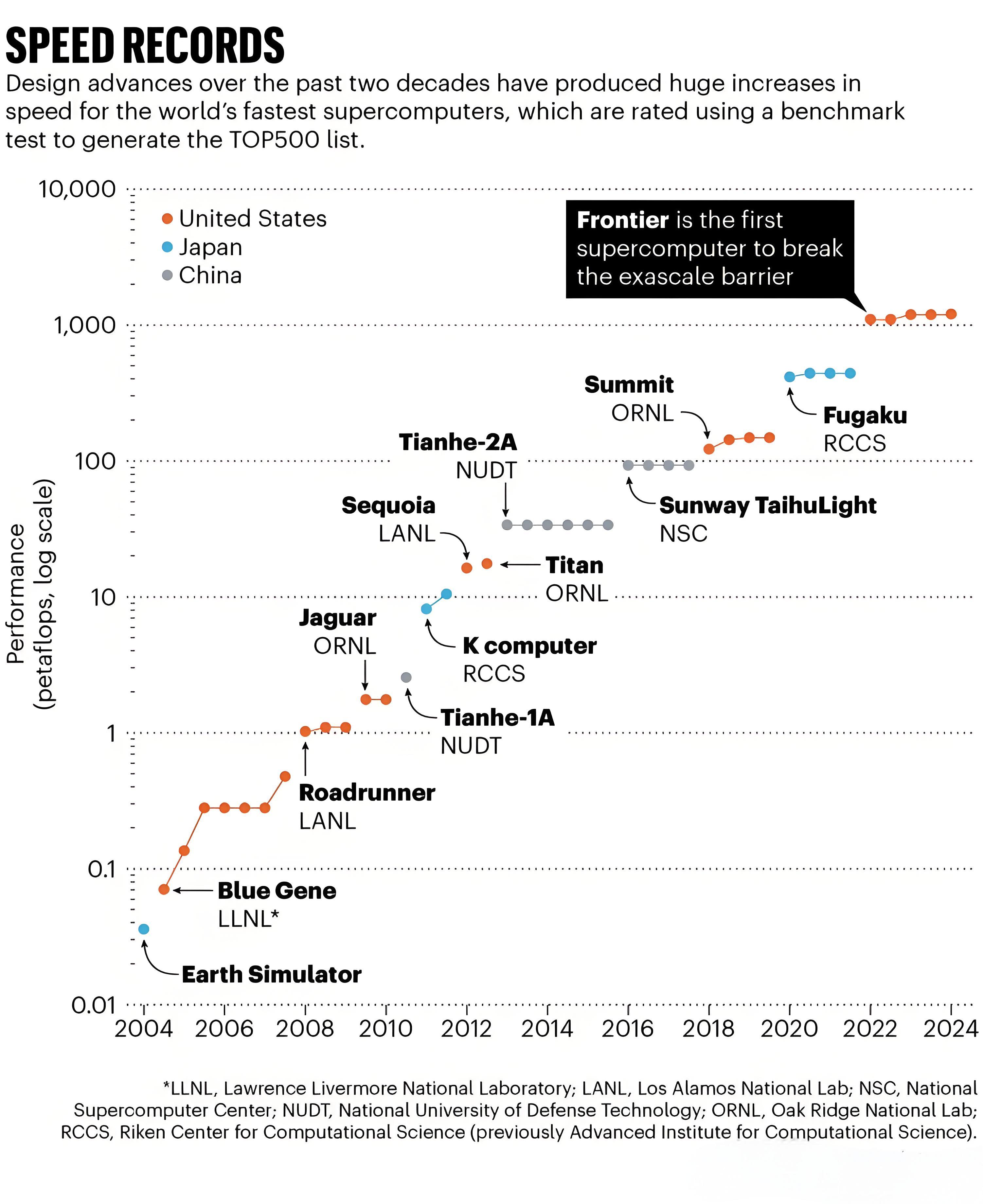

Frontier 配备的是 AMD 的 CPU 和 GPU,有 5 万个处理器(其中包含 3.8 万个 GPU),运算速度为 1.102 exaFLOPS,即每秒 1.102 百亿亿(1018)次浮点运算。这个速度甚至比 10 万台笔记本同时工作还要更快,而且在 2022 年首次亮相时,Frontier 还破了一个纪录 —— 第一次突破了百亿亿次运算速度的门槛。

之所以要追求如此卓越的速度和规模,是为了满足各领域前沿科学研究中模拟计算的需要。

Frontier 十分擅长创建模拟,并能同时捕捉到大尺度的模式和小尺度的细节,比如微小的云滴如何影响气候变暖的速度。如今,研究人员们从世界各地登录 Frontier,创建从亚原子粒子到星系的一切尖端模型,包括模拟蛋白质进行药物发现和涉及、模拟湍流以改进飞机发动机,以及训练能和谷歌、OpenAI 竞争的开源 LLM。

但是,就在今年四月的一天,Frontier 的运作出现了一点意外。Frontier 所在的田纳西州橡树岭国家实验室科学主任 Bronson Messer 表示,为了为了跟上世界各地科学家们的要求,Frontier 的功耗急剧上升,峰值达到了约 27 兆瓦,足以为大约 1 万个家庭供电。

探秘 Frontier「大脑」内部

实验室主任 Messer 形容道,「这些 GPU 运行得非常快,但也愚蠢至极,它们可以一遍又一遍地做同一件事。」这种同时处理多项运算的功能对超算的快速工作非常有用,但除此之外,也没什么其他任务了。这种「愚蠢至极」的背后,是一种通用性,各领域的科学家都可以通过定制代码来运行 GPU。

Frontier 的运转日夜不停,同样连轴转的还有负责运营、维护的工程团队。负责建造这台超算的工程师团队来自惠普公司,其中一位技术人员 Corey Edmonds 表示,他们有一个工程团队会对 Frontier 进行持续监控,判断是否存在故障迹象。比如其中一位夜班人员 Conner Cunningham 的工作时间就是晚 7 点到早 7 点,负责用十多个监视器关注网络和建筑物的安全,并监控当地天气,确保 Frontier 正常运转。

实际上,大多数夜晚都是「平安夜」,Cunningham 一般只需要巡查几次,其余时间都可以在工位上学习。「这项工作有点像消防员,如果发生任何事,需要有人在岗监控。」

助力大科学

Messer 表示,相比其他数据中心,研究人员在 Frontier 上获得的计算资源大约多出十倍。

有了更快的运算速度、更多的计算资源,研究人员们就能做出更加雄心勃勃的「大科学」。

比如,在原子级精度精确地模拟生物过程,像是溶液中的蛋白质或核酸如何与细胞其他部分发生相互作用。今年 5 月,有学者用 Frontier 模拟了含有超过 1550 亿个水分子的立方体形状的水滴,大小约为人类头发宽度的十分之一,是有史以来规模最大的原子级模拟之一。

短期内,研究人员希望模拟细胞器来为实验室提供信息;此外他们还希望将这些高分辨率的模拟结果,与 X 射线自由电子激光器的超快成像相结合,以加速发现。这些工作都是为今后更大的目标做铺垫 —— 从原子开始对整个细胞进行建模。

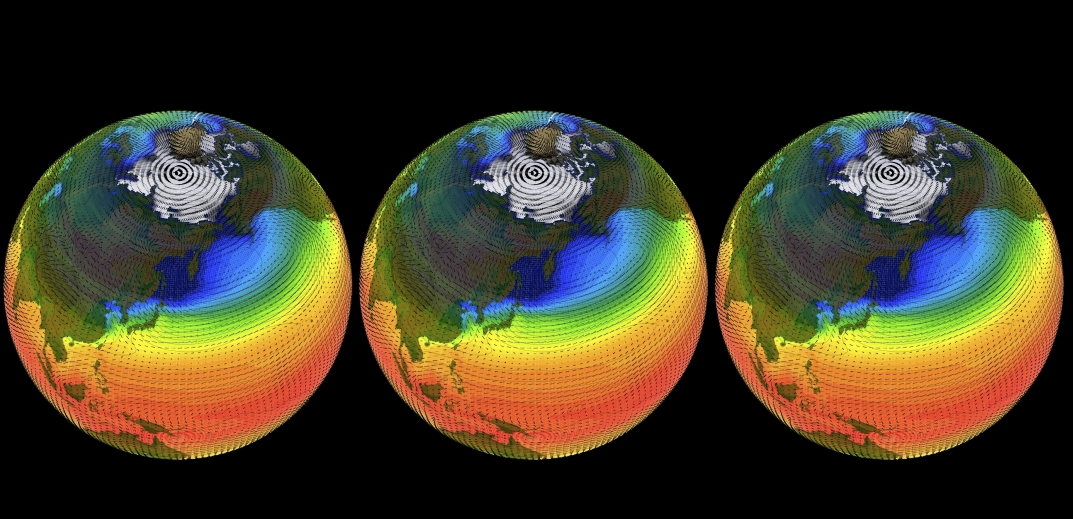

有了 Frontier,气候模型也变得更加精确。去年,气候科学家 Matt Norman 和其他研究人员使用 Frontier 运行了分辨率为 3.25 公里的全球气候模型,其中还结合了分辨率更加精细的复杂的云层运动。

对于一个适用于天气和气候预测的模型,至少需要每天进行一年的模拟运行。Frontier 每天可以模拟 1.26 年,这个速度可以使研究人员能够创建比以前更准确的 50 年预测。如果换到其他计算机上运行,要达到相同的分辨率,同时考虑云的影响,计算速度则会慢得多。

在更大的宇宙级尺度上,Frontier 也能带来更高的分辨率。

匹兹堡大学的天体物理学家 Evan Schneider 也在使用 Frontier,研究银河系大小的星系如何随着年龄的增长而演化。他们创建的星系模型跨越四个数量级,最大规模可达约 10 万光年。而在 Frontier 之前,以类似的分辨率模拟的最大结构是矮星系,质量约为五十分之一。

Frontier 对 AI 意味着什么

由于 AI 领域的研究往往需要吞噬庞大的算力,学术界和工业界的成果存在巨大的鸿沟。有学者统计过,2021 年,96% 的最大的 AI 模型来自工业界。平均而言,工业界模型的规模是学术模型的近 30 倍。这种差异在投资金额方面也很明显。美国的非国防公共机构在 2021 年提供了 15 亿美元支持 AI 研究。同年,全球工业界支出超过 3400 亿美元。而自从 GPT-4、Gemini Ultra 等商业 LLM 发布以来,两者之间的差距又被进一步扩大,这种投资鸿沟导致工业界和学术界可用的计算资源明显不对称。

由于工业界的模型开发以盈利为目的,往往会忽视很多技术发展中必须要面对的重要问题,比如基础研究、低收入群体的需求、评估模型风险、纠正模型偏见等等。如果学术界要承担起这些责任,就需要能和行业规模匹配的算力,这就是 Frontier 的用武之地。

一个最典型的例子,科技公司训练出的 LLM 往往保留不同程度的专有性,但研究者们往往会将自己开发的模型免费提供给任何人使用。马里兰大学帕克分校的计算机科学家 Abhinav Bhatele 表示,这将有助于大学研究人员与公司竞争,「学术界人士训练类似规模模型的唯一方法是获得像 Frontier 这样的资源。」Bhatele 认为,Frontier 等设施在 AI 领域就是发挥着这种至关重要的作用,让更多的人参与到技术开发中,共享成果。

但值得注意的是,这场国家之间、科技公司和非营利机构间的算力基础设施竞赛,依旧在持续,能力强大如 Frontier 也终会有跌落的一天。

橡树岭实验室已经在规划 Frontier 的继任者,名为 Discovery,计算速度将提升 3~5 倍。作为参考,Frontier 相比 2014 年的最快的超算天河二号 A 快了 35 倍,比 2004 年最快的超算 Earth Simulator 快 3.3 万倍。

多年来,能源效率一直是构建更先进超算的关键瓶颈,而在可预见的将来,这个瓶颈估计会持续存在。实验室主任 Messer 表示,「我们本可以在 2012 年建造一台百亿亿次级别的超算,但提供动力的成本太高了,需要多一两个数量级的电力。」

(如有版权问题,请联系删除)